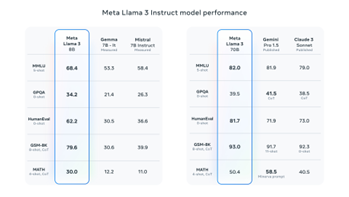

-最先进的大语言模型之一(LLama3)

数据库系统内置AI

Lama3

为了确保Llama 3训练的数据质量最 高,我们开发了一系列数据过滤管道。 包括使用启发式过滤器、NSFW过滤 器、语义去重方法和文本分类器来预测 数据质量。为了在Llama 3模型中有效 利用我们的预训练数据,我们为下游基 准评估开发了一系列详细的扩展法则。 这些扩展法则使我们能够选择最佳数据 混合方案,并就如何最佳利用我们的训 练计算资源做出明智的决策。

旧版数据库系统可能缺乏现代的安全特性,例如强身份验证、加密和数据访问控 制。这使系统容易受到安全漏洞和数据泄露的威胁。

而链天地基于LLama开发,作 为一个开源的大语言模型,这使离线部署成为了可能。这意味着您的数据不会离开 您所部署的计算机,可以说是从根本上杜绝了数据通过网络泄露的问题

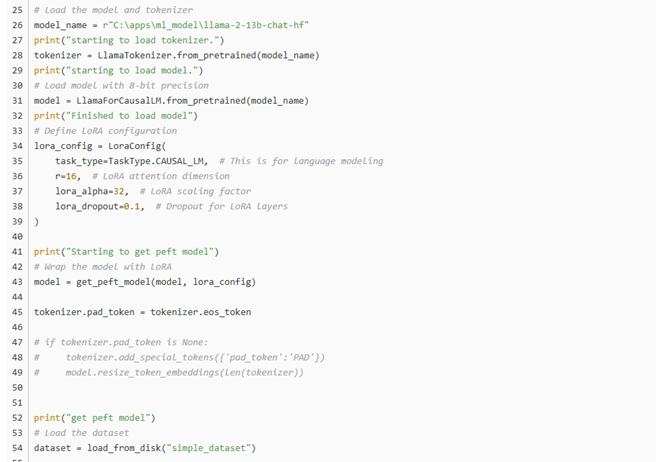

使用LoRA技术对Llama3模型进行微调

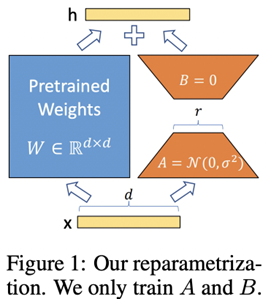

在使用 LoRA 微调模型时,对特定层的 权重更新分为两部分: 预训练权重 (W0): 预训练模型的原始权 重。 LoRA 权重 (ΔW): 在微调过程中学习的 低秩适应权重,用于使模型适应新任 务。 应用 LoRA 后的有效权重 W 计算如下: W_0: 模型的原始权重。 A 和 B: 用于分解权重更新的低秩矩阵 (ΔW = A * B)。 r: 分解的秩(由 LoraCong 中的 rank 参数指定)。 lora_alpha (α): 一个缩放因子,用于 确定 LoRA 权重的相对贡献。

PEFT(Parameter-E cient Fine-Tuning),允许以最少的资源和成本微调模 型。有两种重要的 PEFT 方法:LoRA(Low Rank Adaptation)和 QLoRA (Quantized LoRA),其中预训练模型分别作为量化的 8 位和 4 位权重加载到 GPU。您很可能可以使用 LoRA 或 QLoRA 微调在具有 24GB 内存的单个消费级 GPU 上微调 Llama 2-13B 模型,并且使用 QLoRA 所需的 GPU 内存和微调时间甚 至比 LoRA 更少。

功能多样化

与传统的数据库系统最大的区别在于本 系统的功能多样化,因为内置AI且查询 方式为问答。在商家往系统输入自家的 产品数据后,此系统还可以充当AI客 服,当顾客提出某些需求,AI会充分分 析客户的需求并与系统内的产品数据进 行匹配,从而给出最为贴切的回答。